Prognosen sind schwierig – besonders …

… wenn sie Naturkatastrophen betreffen. „Morgen um 14:00 Uhr wird es in Gmunden ein Gewitter mit starkem Hagel geben.“ – Vorhersagen wie diese sind trotz aller Fortschritte derzeit nicht möglich. Ob dieses Ziel mittelfristig erreicht werden kann, welche Möglichkeiten Simulationen und Gefahrenkarten bieten und wo aktuelle Forschungsprojekte ansetzen, erklären Experten im Gespräch mit APA-Science.

„Vor zehn bis fünfzehn Jahren konnten wir vorhersagen: Morgen sind in Ostösterreich schwere Gewitter möglich. Jetzt prognostizieren wir: Morgen sind in der Obersteiermark schwere Gewitter möglich. Eine deutlich stärkere regionale Eingrenzung ist auf Jahre hinaus nicht absehbar“, erklärt Christoph Wittmann, der die Entwicklung von Vorhersagemodellen bei der Zentralanstalt für Meteorologie und Geodynamik (ZAMG) leitet. Warum das so ist, hat mehrere Ursachen.

Die Atmosphäre ist an jedem Mikrometer definiert. Wettermodelle, die Basisinformationen zu Temperatur, Wind, Wolken, Hagel, Blitz und Co. liefern, greifen aber auf Rechen- bzw. Gitterpunkte zurück, die weit voneinander entfernt sind. Die Modelle haben also eine bestimmte – beschränkte – Auflösung. „In einem Gewitter spielt sich die Bildung von Wassertröpfchen, Eiskristallen und Hagelkörnern in den Wolken auf kleinstem Raum ab. Wir müssen das mit Modellen vorhersagen, die einen Gitterpunktsabstand von beispielsweise einem Kilometer haben. Das ist eine ganz andere Skala. Die Auflösung müsste also noch deutlich höher werden, um diese Prozesse explizit berechnen zu können“, so Wittmann. Da scheitere man im Moment aber an den Rechnerressourcen.

Regionale Modelle rechnen zwei bis drei Tage voraus

In den vergangenen Jahren sei die Leistungsfähigkeit der Hochleistungsrechner allerdings massiv gestiegen. Dadurch kann der dreidimensionale Raster, auf dem die Wettermodelle die zeitliche Entwicklung des Zustands der Atmosphäre und die damit verbundenen Wetterphänomene rechnen, noch feiner werden. Abhängig ist das aber vom angestrebten Prognose- und Warnzeitraum. Manche Modelle rechnen viele Tage in die Zukunft und können erste Hinweise auf Wetterextreme liefern – das sind die globalen Wettermodelle. Regionale Modelle schauen maximal zwei bis drei Tage voraus. Als Regel gilt: Je kürzer der Prognosezeitraum, desto feiner und hochauflösender wird das verwendete Rechenraster. Und hier stoßen auch Hochleistungsrechner schnell an ihre Grenzen.

Die bestaufgelösten globalen Modelle rechnen mit einem Raster, bei dem die Gitterpunkte im Schnitt rund zehn Kilometer voneinander entfernt sind. Diese würden von großen Anbietern wie dem Europäischen Zentrum für mittelfristige Wettervorhersage (ECMWF) mit Sitz in Großbritannien zugeliefert, Österreich sei hier „Mit-Finanzier“. Die ZAMG rechne regionale Modelle, die beispielsweise auf den Alpenraum bezogen sind, mit einem Raster von einem Kilometer und zunehmend auch darunter. Dadurch werde die räumliche Auflösung feiner und umfasse auch vertikal mehr und dünnere Schichten. „Wir schauen maximal zwei bis drei Tage in die Zukunft. Das ist das, was man mit den aktuellen Hochleistungsrechnern für diese Auflösung schafft und was auch Sinn macht. Es gibt auch Modelle, die nur für die nächsten Stunden in schneller Folge Daten liefern“, sagt Wittmann. Die längeren Zeiträume überlasse man den globalen Modellen.

Ein weiterer wichtiger Punkt ist der sogenannte Ausgangszustand: „Die Atmosphäre ist hochgradig chaotisch. Wenn man mit einem kleinen Fehler am Anfang wegrechnet, dann verstärkt sich der völlig unkontrolliert und führt zu wachsenden Fehlern mit Fortdauer der Prognoserechnung“, erläutert der Experte. Deshalb würden inzwischen statt einer Modellrechnung immer mehrere verschiedene Modellszenarien durchgerechnet – 10, 15, 20, je nachdem, was man sich leisten kann, um mögliche Unsicherheitsfaktoren wie Messfehler oder eine nicht optimale Modellkonzeption zu quantifizieren. Diese Modelle führen laut Wittmann zu unterschiedlichen Vorhersagen und nicht zu einer Antwort auf die Frage: Ein Gewitter tritt auf, ja oder nein. Vielmehr würden sich daraus Wahrscheinlichkeiten ergeben, was sich auch in der Öffentlichkeit immer mehr durchsetze.

Mehr Beobachtungsdaten notwendig

Für genauere Prognosen bräuchte es auch noch mehr fein auflösende Beobachtungsdaten, die möglichst ohne Messfehler sind. Schon jetzt werden unzählige Quellen „angezapft“. Das beginnt bei den Wettersatelliten, die einen großen Beitrag leisten, geht über Wetterballons bis hin zu Flugzeugen. „Manche Verkehrsflugzeuge haben spezielle Sensoren montiert und liefern Messwerte während des Fluges. Außerdem können mehr oder weniger von jedem Verkehrsflugzeug, das in der Luft ist, Wetterdaten abgeleitet werden“, verweist der Modellentwickler auf eine immer wichtiger werdende Quelle. Denn gewisse Flugparameter, die das Flugzeug über das Sekundärradar melde, würden zeigen, wie hoch die Windgeschwindigkeit oder die Temperatur an dem Punkt ist, wo das Flugzeug gerade unterwegs ist.

Berge in Bewegung

Neue Gefahrenlagen entstehen auch durch vom Klimawandel ausgelöste Veränderungen in den Gebirgsregionen. Bestehende Einschätzungen entsprechend zu adaptieren, sei „eine der großen Herausforderungen“ der kommenden Jahre, so der Schweizer Geowissenschafter Holger Frey von der Universität Zürich im Gespräch mit der APA. Man müsse Gefahrenkarten künftig stärker als „ein dynamisches Werkzeug“ begreifen und sie „in kürzeren Abständen adaptieren“, sagte er kürzlich bei der in Innsbruck abgehaltenen „International Mountain Conference“.

Dabei könnten Tools helfen, die Jan Beutel mitentwickelt hat. Der deutsche Informatiker, der im Pitztal die Alpen lieben gelernt hat, ist vor zwei Jahren von der ETH Zürich an die Universität Innsbruck gewechselt. „Eine Uni, die meine beiden Leidenschaften – Berge und Data Science – als Forschungsschwerpunkte hat: Das war für mich der Trigger“, erklärt Beutel. Seinen größten Schatz durfte er nach Tirol mitnehmen: die Daten einer seit 2006 laufenden Messreihe am Matterhorn.

Zu einem Zeitpunkt, zu dem die Bluetooth-Technik noch in den Kinderschuhen steckte, wurden von Forschern dringend Anwendungsmöglichkeiten für digitale Datenübertragung gesucht. Beutel und sein Team entwickelten Sensoren, die permanent Umweltdaten erheben, aufzeichnen und weiterschicken. Im Rahmen des PermaSense-Projekts werden in Bohrlöchern von rund einem Meter Tiefe Daten wie Felstemperaturen und Neigungs- oder Spaltbewegungen registriert.

In der Schweiz hätten Industrie und Behörden die von ihnen entwickelte Technologie aufgegriffen und in ausgewählten Gebieten auch bereits zum Einsatz gebracht, schildert der Experte für Sensornetzwerke. In den Westalpen, wo einige Dörfer direkt an der Permafrost-Grenze lägen und daher über Evakuierungspläne verfügen müssten, sei die Gefahrenlage jedoch deutlich ausgeprägter als in Österreich. Dennoch sieht Beutel auch hier Einsatzgebiete für seine Sensoren. Die richtige Auswahl des Einsatzgebietes und passende Instrumentierung seien aber heikle Aufgaben – man könne schließlich „nicht jeden Fleck“ mit Messgeräten versorgen.

Auch Crowd-Daten werden integriert

Zurück zu den Quellen der Modellrechner: Am Boden liefern Sensorsysteme viele Daten. „Da gibt es beispielsweise Wind-Profiler und LIDAR-Systeme, quasi Laser, die in die Atmosphäre schauen, Wolkenprofile messen und oft am Flughafen stehen. Zunehmend interessant sind Crowd-Daten, die beispielsweise von Wetterstationen von Privatpersonen stammen. Die kann man verwerten, wenn die Datenqualität stimmt“, so Wittmann. Grundsätzlich sei die Kontrolle der Beobachtungsdaten extrem wichtig, weil sie sehr unterschiedliche Qualitäten aufweisen würden. „Das sind Millionen Daten pro Tag, die man prüfen muss. Nur eine kleine Menge schafft es in den Anfangszustand der Modellrechnung.“ Weil die Daten völlig unregelmäßig im Raum verteilt seien, man aber auf einem regelmäßigen Gitter rechne, müssten außerdem verschiedenste mathematische Verfahren angewendet werden, um diese Daten auf das Gitter zu bringen.

Verbesserungen gebe es auch bei statischen Daten, wie den sogenannten physiographischen Daten, etwa zu Landnutzung und Vegetation. Wie sieht es mit der aktuellen Bebauung aus? Wie hoch ist der Grünanteil? „Der Boden hat im Modell einen großen Einfluss auf die Prognose, wenn man beispielsweise die Verdunstung in die Atmosphäre berechnet, die für die Wolkenbildung eine Rolle spielt.“ Auch die Wettermodelle selbst sind nicht perfekt und werden laufend weiterentwickelt.

Größe erleichtert Prognose

Ein weiterer Merksatz: Je größer das Wettersystem, das das Extrem verursacht, desto leichter und besser ist eine Vorhersage. „Stürme von großen Tiefs, die sich vom Atlantik zu uns reinbewegen, sind schon Tage vorher gut prognostizierbar. Das sind großflächige Sturmereignisse. Anders ist das bei Gewittern im Sommer, wo Gewitter- und Sturmböen sehr lokal, sehr kleinräumig auftreten. Da sind die verursachenden Systeme deutlich kleiner und die Vorhersagbarkeit wesentlich geringer“, beschreibt Wittmann. Das gelte auch beim Niederschlag: „Großflächige Hochwasserereignisse, wie Donau-Hochwässer, sind verbunden mit großflächigen Extremniederschlägen und gut vorhersagbar. Da gibt es kaum Überraschungen. Bei kleinräumigen Hochwasser- oder Flutereignisse, die durch regionale Gewitter auftreten, ist das schon schwieriger.“

Hier habe sich in den vergangenen Jahren aber viel getan: „Man kann die Regionen, in denen starke Gewitter auftreten, immer besser eingrenzen. Aber es ist weiter nicht möglich, zu sagen: An dem Punkt, um die Uhrzeit wird morgen ein Gewitter samt Starkregen auftreten. Das geht einfach noch nicht. Man kann sagen: Morgen ist die Chance in Ostösterreich sehr hoch, das Starkgewitter mit lokalen Überflutungen auftreten. Ein halbe bis ganze Stunde vorher ist das Limit. Da kann man versuchen, genauer vorherzusagen, wo ein Phänomen auftreten wird“, so der Experte.

SimCity für Katastrophen

Hochwasser- und Starkregenereignisse schnell und zuverlässig simulieren sowie leicht verständlich visualisieren: Das soll die Software Visdom ermöglichen, an der am Wiener Forschungszentrum für Virtual Reality und Visualisierung (VRVis) zusammen mit Partnern seit mehr als einem Jahrzehnt geforscht und gefeilt wird. Simulation und Visualisierung in 3D sind aber nur der erste Schritt. Darauf aufbauend kann anhand von verschiedenen Eingriffen – von Sandsäcken und temporären Barrieren bis hin zu baulichen Adaptionen – ausprobiert werden, welche davon wie und warum am besten gegen die Gefährdungen wirken. Ähnlich Computersimulationsspielen wie SimCity lassen sich mit der Software verschiedenste Szenarien sehr intuitiv darstellen, erklärt Andreas Buttinger-Kreuzhuber, Teil des Visdom-Kernteams am VRVis.

Das erleichtere es, gute Entscheidungen sowohl in der Prävention als auch im Akutfall zu treffen. Die Ergebnisse erscheinen je nach Anwendung innerhalb von Sekunden auf dem Bildschirm. Um diese Geschwindigkeit zu erreichen, sei viel Forschung notwendig gewesen. Die 3D-Visualisierung und der einfache Zugriff über den Browser würden wiederum die Öffentlichkeitsarbeit und die Aufklärung der Allgemeinheit erleichtern. Denn, ob das eigene Haus oder die eigene Straße überschwemmt werden oder nicht, berührt jeden Menschen, so Buttinger-Kreuzhuber.

Mittels eines digitalen Zwillings und der Navigation in der Zeit lässt sich mit Visdom nachvollziehen, welche Fließwege das Wasser nimmt und wo kritische Hotspots entstehen. Dieser digitale Zwilling kann den Angaben zufolge auch extrem große Gebiete abbilden, wofür eine Reihe an verschiedenen Daten und Datenquellen gebündelt werden: Hier reicht die Palette von hochaufgelösten Geländemodellen und Gebäudekatastern bis zu Daten zu Landnutzung, hydrologischen Einzugsgebieten, Kanalnetzen, Niederschlägen und Wasserständen.

Die Hochwassergefährdung für Gebäude in Österreich mittels Visdom ist auf der Plattform www.hora.gv.at kostenlos abrufbar und soll bald auch für die Öffentlichkeit in 3D verfügbar sein. Außerdem sei die Software bereits bei mehr als 75 heimischen Gemeinden im Einsatz gewesen. Weitere Projekte gibt es in Deutschland, Dänemark und der Schweden. Künftig soll Visdom für verschiedenste Szenarien, die mit Niederschlag und Wasser zu tun haben, verwendbar sein. Das beginnt bei der Katastrophenschutzplanung, geht über die Entwicklung von resilienten Städten und reicht bis zu nachhaltigen Konzepten wie blau-grüner Infrastruktur, wo Wasser auch gespeichert wird, um Spitzenbelastungen zu entschärfen.

Eigene Ansätze für Langfrist-Phänomene

Mit den Parametern, die die Wettermodelle liefern, könnten alle wichtigen Extrema abgedeckt werden. Aber nicht jeder Parameter ist laut Wittmann gleich gut vorhersagbar. Bei der Blitzvorhersage ist wichtig, wie stark die Vertikalwinde sein werden und sich Eis und flüssige Wolkenpartikel verteilen, weil Blitze in der Wolke durch starke Vertikalbewegungen entstehen, wenn flüssige und feste Teilchen aneinander reiben. Eine Reihe von Katastrophen, die wetterinduziert sind, wird mit nachgeschalteten Modellen vorhergesagt. Der hydrologische Dienst bekommt Modelldaten und berechnet auf dieser Basis die Abflussmengen in den Flüssen. Manche Impact-Modelle zielen ganz lokal auf den urbanen Bereich ab. Eigene Ansätze existieren für Phänomene, die nicht durch kurzfristige Wetterveränderungen hervorgerufen werden, wie Hitzeperioden oder Dürreereignisse.

„In den kommenden Jahren werden wir bei der räumlichen Auflösung und damit bei der regionalen Eingrenzung große Fortschritte machen“, wagt Wittmann eine Prognose: „Was auch in 15 Jahren noch nicht möglich sein wird, sind Prognosen wie: Morgen tritt in Wien im 3. Bezirk um 15:30 Uhr ein Gewitter auf.“ Auch bei der längerfristigen Vorhersage werde es Verbesserungen geben: „Heute ist die Prognose für den Tag 5 so gut wie die Prognose vor zehn Jahren für Tag 3. In 15 Jahren wird man dieselbe Prognosequalität, die man jetzt für Tag 5 hat, für Tag 7 oder 8 haben. Der seriös vorhersagbare Zeitraum wird sich weiter in die Zukunft schieben.“ Eine Sättigung, also die Abflachung der Verbesserungen, sei vorerst nicht in Sicht.

Wo Hänge rutschen

Daten gibt es zu Hangrutschungen bereits zuhauf. Diese nun zu harmonisieren, zu ergänzen und zu verbessern, um daraus letztendlich robuste Gefährdungskarten zu entwickeln, ist Ziel des Projekts gAia. Bisher gibt es vor allem historische Archivdaten, Ergebnisse aus Feldkartierungen und ergänzende Informationen aus Fernerkundungsdaten. Digitale Höhenmodelle auf Basis von luftgestütztem Laserscanning (ALS) und Erdbeobachtungsdaten der Sentinel-Missionen werden dagegen nur sehr eingeschränkt genutzt. Nun sollen mithilfe von Künstlicher Intelligenz (KI) Methoden entwickelt werden, diese Datenquellen zu fusionieren.

Auf diese Weise würden sich potenziell gefährdende Gegebenheiten, die zu Hangrutschungen führen, automatisiert erkennen und in einer verbesserten Gefahrenhinweiskarte darstellen lassen. Damit soll die Entscheidungsfindung der Bedarfsträger beim staatlichen Krisen- und Katastrophenschutzmanagement unterstützt werden. Herausfordernd dabei seien sowohl die Harmonisierung der bestehenden Inventar-Daten, die Qualität der Satellitendaten als auch die schiere Menge – Stichwort Big data.

Auch wenn eine Vorhersage von Hangrutschungen nicht möglich sei, könnten so Bereiche identifiziert werden, die eine erhöhte Wahrscheinlichkeit für diese Ereignisse aufweisen, erklären Michael Avian von der ZAMG und Marc Ostermann von der Geologischen Bundesanstalt (GBA). Partner des FFG-geförderten und von SBA Research geleiteten Projekts sind ZAMG, AIT Austrian Institute of Technology, GeoVille Information Systems and Data Processing GmbH, Disaster Competence Network Austria (DCNA), GBA und das Bundesministerium für Landesverteidigung.

Langsamen Hangbewegungen widmet sich derzeit das Projekt DRAGON, für das verschiedene Technologien und Plattformen integriert werden. Ziel ist, für zwei aktive Großhangbewegungen in Tirol (Steinlenen und Malgrube) ein möglichst genaues dreidimensionales kinematisches Modell zu erstellen, das eine Prognose über den weiteren Verlauf des Hangversagens ermöglicht. Die Ergebnisse sollen dann auf andere Massenbewegungen dieses Typs angewandt werden können. Das Projektkonsortium besteht aus der GBA, dem Institut für Angewandte Geologie der BOKU und den KMUs: Sky4Geo und EOG GmbH.

Regionalisierung verschafft Gehör und Vertrauen

Je genauer die Vorhersagen und Einschätzungen, desto besser, denn eine Regionalisierung der Prognosen und Warnungen verschafft mehr Gehör und Vertrauen , meint Hans Starl vom Elementarschaden Präventionszentrum (EPZ): „Eine Warnung für ein ganzes Bundesland ignoriert jeder. Auf Bezirksebene wird es schon besser, aber wenn man es schafft das auf Gemeindeebene zu bringen, kann man zielgerichtet informieren.“ Bei der Bewusstseinsbildung in Kommunen und der Bevölkerung gebe es generell noch Nachholbedarf.

Gegengesteuert wird beispielsweise mit dem Vorsorge-Check Naturgefahren im Klimawandel. Hier vermitteln Expertinnen und Experten welche Gefahren für die jeweilige Gemeinde relevant sind und wie man gegensteuern kann, um etwa durch angepasstes Bauen Schäden zu minimieren. „Auch für das Verhalten im Ernstfall kann man vorsorgen. Ist bekannt, ob der Kindergarten in der Hochwasserzone liegt? Wo sind wie viele bettlägerige Personen zu evakuieren?“, verweist der Bautechniker auf mögliche Fragestellungen.

Er plädiert auch für „Prognosen mit gesundem Hausverstand“: Schon Haus-, Flur- und Hofnamen würden oft auf „Eigenschaften“ von Grundstücken und etwaige Gefahrensituationen hindeuten. „Bei einem Drittel der Objekte lässt sich anhand der Adressen grob zuordnen, welches Problem auf die Bewohner zukommt“, so Starl: „Wenn die Adresse ‚In der Au‘, ‚Am Moorbad‘, ‚Gmös‘ oder ‚Ried‘ – das heißt auf althochdeutsch ’sumpfige Wiese‘ – lautet oder wenn man weiß, dass Sägewerke häufig an Bächen stehen, hat man eigentlich schon gute Hinweise.“

Digitale Landkarte zeigt Gefährdungen

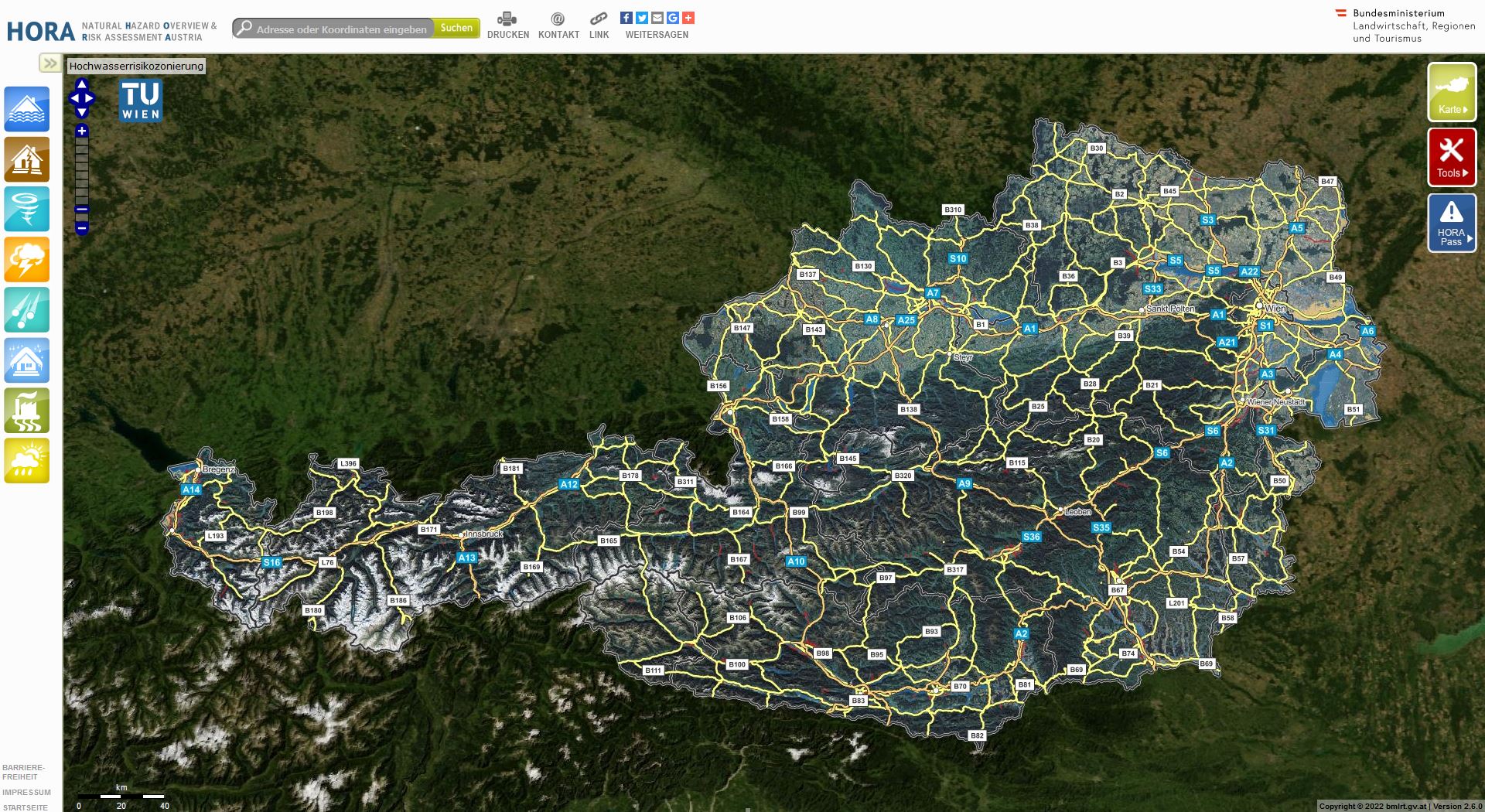

Welche Gefahren konkret für das eigene Haus oder Grundstück bestehen, lässt sich auf der digitalen Gefahrenlandkarte HORA (Natural Hazard Overview & Risk Assessment Austria) erkennen. Neben den zahlreichen regionalen Informationsangeboten in den einzelnen Bundesländern bietet die Plattform einen Überblick über acht Naturgefahren und deren erwartete Intensität für jeden beliebigen Standort in Österreich. So soll auch die Eigenvorsorge, was beispielsweise Hochwasser, Erdbeben, Sturm, Hagel und Schnee anbelangt, verbessert werden. Zudem gibt es aktuelle Wetterwarnungen.

Einen wichtigen Hinweis auf eventuelle Risiken liefern Gefahrenkarten, die ständig weiterentwickelt werden. „Mit der Hochwasserzonierungskarte und der baldigen Neuauflage der Hagelkarte sind wir europaweit vorne dabei. Die Erdbebenkarten sind international sehr einheitlich und bei den Rutschungs-, Wildbach- und Lawinenkarten profitieren die Alpenländer von der jahrhundertelangen Erfahrung. Da muss nur beachtet werden, was der Klimawandel für einen Einfluss hat“, fasst der Experte zusammen. Großes Potenzial haben seiner Meinung nach die Oberflächenwasserkarten.

Mit Hochwasser habe man langjährige Erfahrungen, künftig würden die Schäden durch pluvial abfließendes Wasser zunehmen – ein Überbegriff für Bezeichnungen wie Starkregen, Sturzflut, Hangwasser, wild abfließendes Wasser und Co. Gemeint ist Wasser, das vom Hang in das Hauptgerinne fließt, im Gegensatz zu fluvial fließendem Wasser, also die Überschwemmung aus einem Gewässer heraus. „Für entsprechende Karten werden Parameter wie Niederschlag, Einzugsgebiet, Oberflächen (Straße, Wald, Wiese?) aufbauend auf einem digitalen Geländemodell in ein zweidimensionales hydraulisches Modell gepackt“, so Starl.

Laserscanner „übersehen“ eingebaute Rohre

Für die Ergebnisinterpretation sind aber eine Plausibilitätsprüfung und Fachwissen notwendig, weil beispielsweise eingebaute Rohre für Laserscanner nur sehr schwer erkennbar sind und den Abfluss beeinflussen können. „Da wird versucht, mit Künstlicher Intelligenz gegenzusteuern. Auch wenn es in das innerurbane Gebiet geht, steigt die Komplexität, etwa in Hinblick auf Kanäle und Co. Das ist derzeit noch viel manuelle Arbeit. Will man das großflächig machen, muss eine KI aushelfen“, erklärt Starl. Dies werde umso wichtiger, da hochintensive Regenereignisse mit gebäudeschädigendem Verlauf derzeit zunehmen würden und es kaum Gefahrenbewusstsein gebe.

„Prävention ist nicht des Menschen höchstes Gut. Reagiert wird meist erst, wenn der Leidens- und Handlungsdruck zu groß wird“, so Starl, der warnt: „Wenn wir weiter überall bauen, ohne zu beachten, was passieren kann, wird sich das Potenzial der Schäden so exorbitant erhöhen, dass es irgendwann nicht mehr zu bewältigen ist. Die Feuerwehr kommt nicht mehr mit dem Pumpen nach, die Versicherung nicht mehr mit dem Bezahlen und die Bewohner verzweifeln, wenn sie alle drei Jahre einen vollen Keller haben und der Hagel das Dach zerstört.“