Der unwissende Algorithmus

Wissen ist Macht? Möglich, aber manchmal ist es gut, weniger zu wissen – etwa bei Empfehlungssystemen, die anhand von erlernten Daten automatisch Vorschläge generieren. Wie solche Algorithmen ausgerechnet durch weniger Wissen verbessert können und was eigentlich ein “fairer” Algorithmus ist, erklärt Markus Schedl von der JKU anhand von Musikstreamingdiensten.

Wer kennt das nicht: Wer einmal in Spotify in eine bestimmte Musikrichtung gehört hat, bekommt nun laufend ähnliche Vorschläge – und zwischendurch Folgen von Bibi und Tina von dem einen Mal, als die Tochter sich das iPad gekrallt hat. Dahinter stehen sogenannte “Recommender-Dienste”, also Softwaresysteme, die Vorhersagen dazu treffen, wie hoch das Interesse eines Users an einem Dienst ist, und darauf basierend Empfehlungen für die weitere Suche abgeben.

Recommender-Systeme leiden häufig an einem sogenannten “Popularitätsbias”: Während beliebte Lieder viel Aufmerksamkeit erhalten und darauf basierend häufiger vorgeschlagen werden, bleiben weniger beliebte unterrepräsentiert und werden seltener vorgeschlagen. (Mehr über den Popularitätsbias in “Wie digitale Stereotype aus der Welt geschaffen werden sollen”).

Besonders leicht ersichtlich ist dieses Ungleichgewicht im Musikgeschäft, wo beispielsweise Frauen mit weniger als einem Drittel der Artists deutlich unterrepräsentiert sind – und in Folge seltener vorgeschlagen werden, weniger Möglichkeiten haben, Beliebtheit zu erlangen, und wiederum seltener vorgeschlagen werden. Ein Teufelskreis (Näheres über die verschiedenen Arten von Bias lesen Sie in “Man kann nicht nicht diskriminieren”).

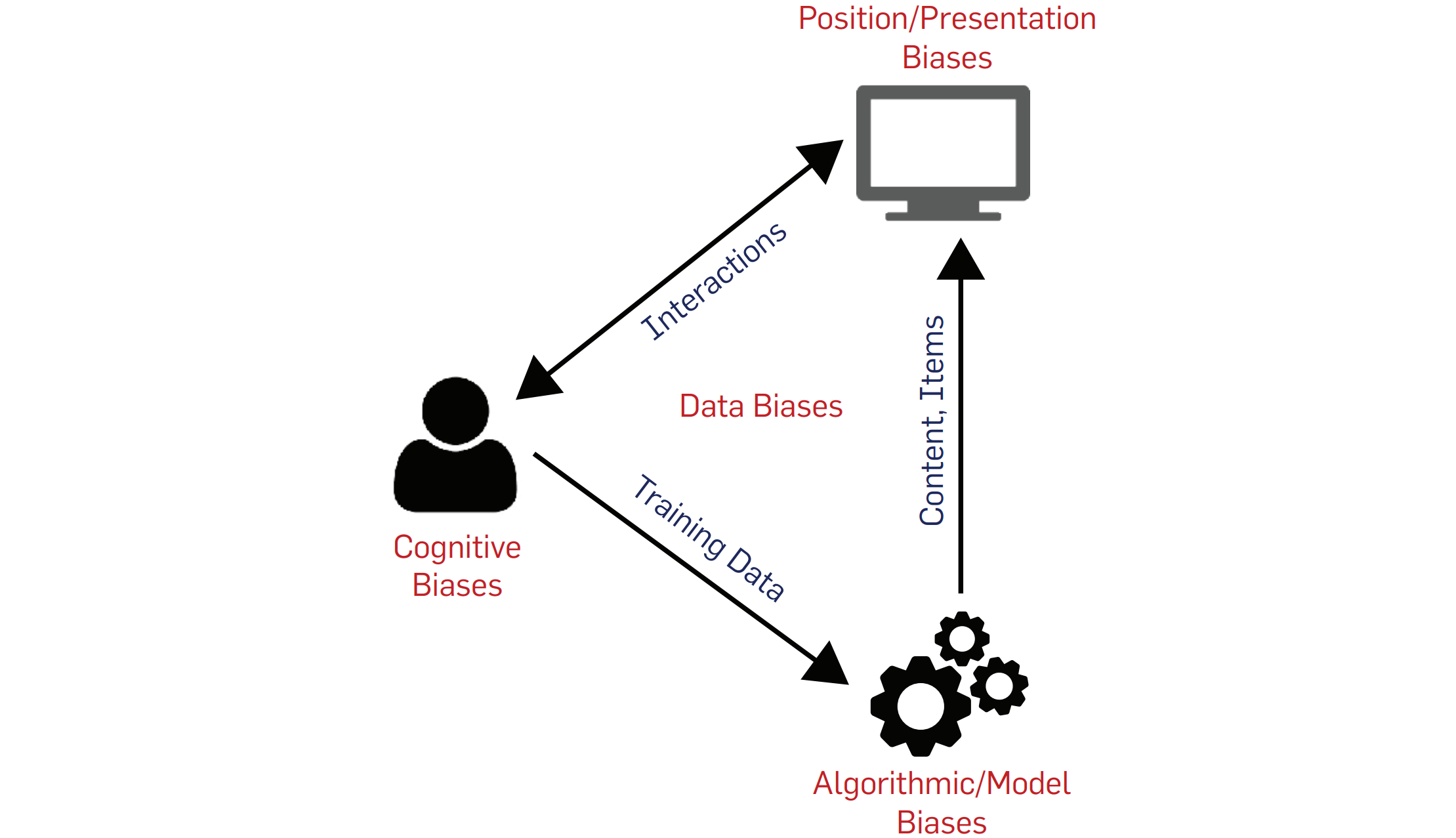

In Suchmaschinen und Empfehlungssystemen gibt es unterschiedliche Arten von Biases

In Suchmaschinen und Empfehlungssystemen gibt es unterschiedliche Arten von Biases

“Fairness through Unawareness”

Wie man Algorithmen (etwa von Spotify und Youtube) fairer machen kann, damit beschäftigt sich Markus Schedl vom Institut für Computational Perception an der Johannes Kepler Universität JKU Linz. Die Forscher befassen sich dafür mit zwei Ansätzen:

Beim ersten Ansatz werden die Trainingsdaten verändert und “der Algorithmus ausgeglichener trainiert, indem man entweder die Daten der unterrepräsentierten Gruppe erhöht (also beispielweise von Frauen generierte Datenpunkte dupliziert; Anm.) oder zufällig Datenpunkte von Männern weglässt. Dabei geht aber natürlich Information verloren, das ist also nicht der optimale Weg.” Außerdem müsse man aufpassen, “dass man dadurch nicht die Qualität der jeweiligen andere Gruppe beeinträchtigt. Das sieht man hier oft: Dass zwar alle Gruppen die gleiche Qualität haben, die der überrepräsentierten Gruppe aber im Grunde weniger geworden ist.”

Der zweite Ansatz nennt sich “Fairness through Unawareness”. „So ein Empfehlungssystem lernt aus Interaktionen; was Nutzer oder Nutzerinnen hören, welche Filme geschaut werden, auf welche Bilder geklickt wird, und darauf aufbauend wird ein User Profil erstellt”, anhand dessen der Algorithmus dem User neue Songs etc. empfiehlt. Stereotype Informationen sollen in dem “Fairness through Unawareness”-Ansatz aus dem Algorithmus rausgelernt werden, damit beispielsweise Musikvorschläge nicht mehr nach dem angelernten Geschlecht des Users oder der Userin, sondern rein nach seinen bzw. ihren Vorlieben gemacht würden.

Schwarze Musiklöcher bekämpfen

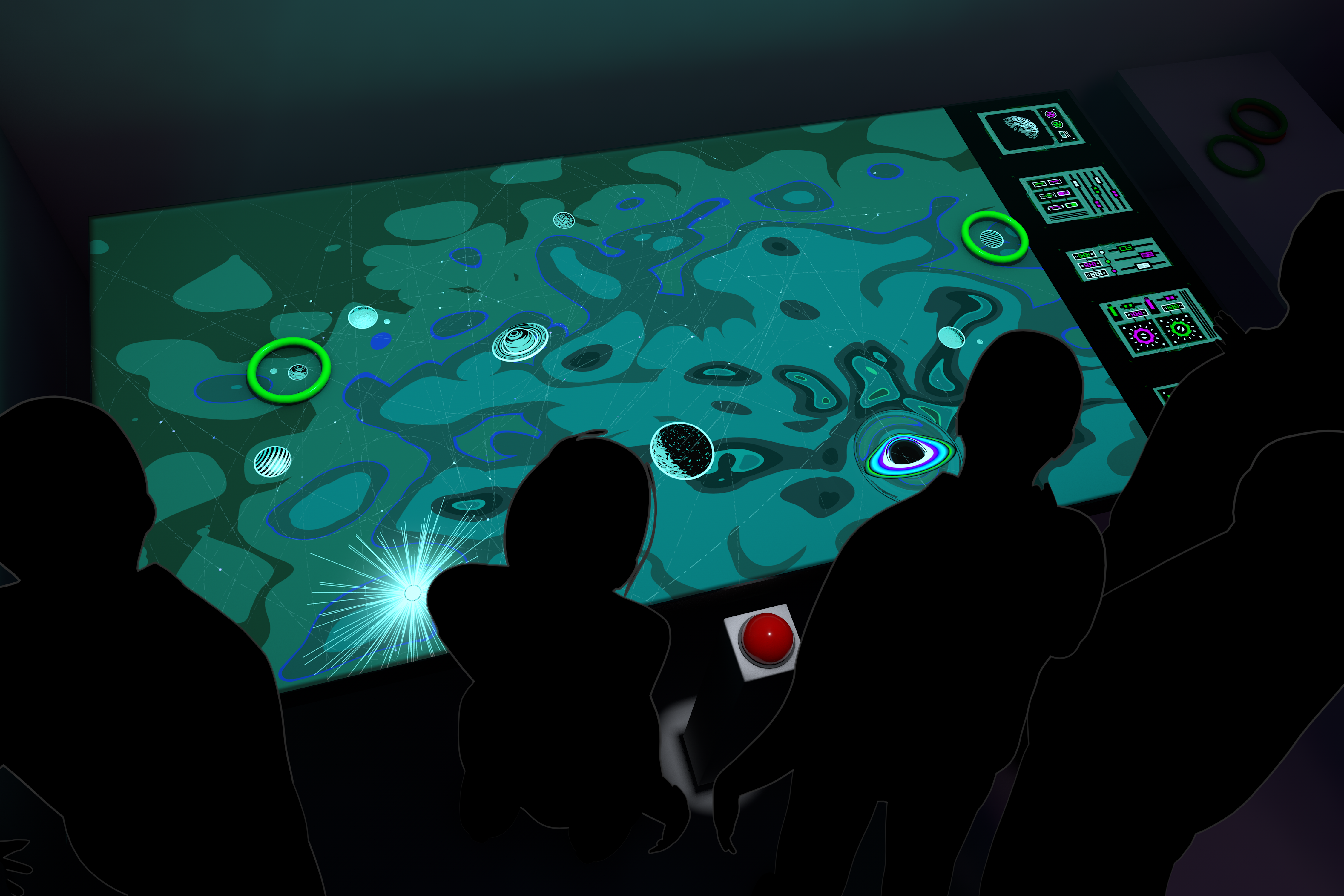

Im Ars Electronica-Projekt “Black Holes of Popularity” stellten Schedl und sein Team die Musikwelt als Universum dar, bei dem Lieder (je nach ihrer Popularität) kleine, unscheinbare Planeten oder strahlende Sonnen waren. Die beliebtesten wurden zu schwarzen Löchern, die keinen Platz für andere Musik lassen und alles rundherum verschlucken. Im Kampf gegen Recommendation-Algorithmen konnte man sich beim Projekt daran versuchen, gefährdete Tracks davor zu schützen, schwarzen Löchern zum Opfer zu fallen.

Wer bestimmt, was fair ist?

Die Frage nach der Fairness eines Algorithmus ist eine schwierige, denn “das Konzept der Fairness existiert im juristischen Bereich gar nicht“. Was als fair angesehen wird, ist von vielen Faktoren abhängig, nicht zuletzt der Kultur. Des Weiteren stelle sich folgende Problematik, so Schedl: “Wenn man gebiasde Daten hat, ist es das Ziel, diesen Bias zu replizieren oder möchte man eine ausgeglichenere Verteilung?” Wenn etwa bei Heavy-Metal-Musik Interpretinnen mit nur zehn Prozent unterrepräsentiert sind, sollte das Ziel dann überhaupt eine 50:50-Verteilung sein? “Das spiegelt dann nicht die Realität wider“, verweist Schedl auf die Begriffe “societal bias” und “statistical bias”. Während der “societal bias” sich auf die Diskrepanz zwischen der realen Welt und der perfekten Welt bezieht, bezieht sich der “statistical bias” auf den Unterschied zwischen der Welt, wie sie ist, und der Welt, die der Algorithmus modelliert.

Rein zufällige Vorschläge durch solche Systeme seien aber auch keine Lösung, so Schedl. “Um bei der Musik zu bleiben: Es gibt viele hunderttausende Musikstücke, aber nur ein kleiner Prozentsatz ist populär. Wenn man ein Empfehlungssystem bastelt, das jedem Inhalt die gleiche Chance gibt, verliert man in kürzester Zeit den Großteil der User, weil diese dann nur mehr Lieder zu hören bekommen, die keiner kennt. Zu viel Personalisierung ist nicht gut, da sind wir dann bei der Filterbubble-Problematik – aber das andere Extrem ist auch schlecht”, wenn man etwa jedem Hobbygitarristen die gleichen Chancen einräume wie einem professionell erstellten Musikvideo. “So ein Ansatz würde dazu führen, dass sehr schnell sehr viele Leute die Plattform verlassen.”

Das Bewusstsein schärfen

Was also kann ich als User tun, um verzerrte Vorschläge zu vermeiden? Zunächst einmal müsse das eigene Bewusstsein für die Problematik geschärft werden, so Schedl. Das gehe am einfachsten, indem man auf derselben Plattform mehrere Accounts erstellt und mit unterschiedlichen Eingabedaten füttert, “um ein Gefühl zu bekommen, was Empfehlungssysteme aus den Daten machen.”

Alternativ empfiehlt Schedl die Plattform “Every Noise at Once”, wo Musikerkundung auf einer sehr feingranularen Genreeinteilung basiert, wie Namen wie Goa Psytrance, Progressive Breaks oder Bubble Trance deutlich machen. “Das ist die andere Herangehensweise”, so Schedl, “keine personalisierten Vorschläge zu machen, sondern Explorationsinterfaces zu erstellen.”

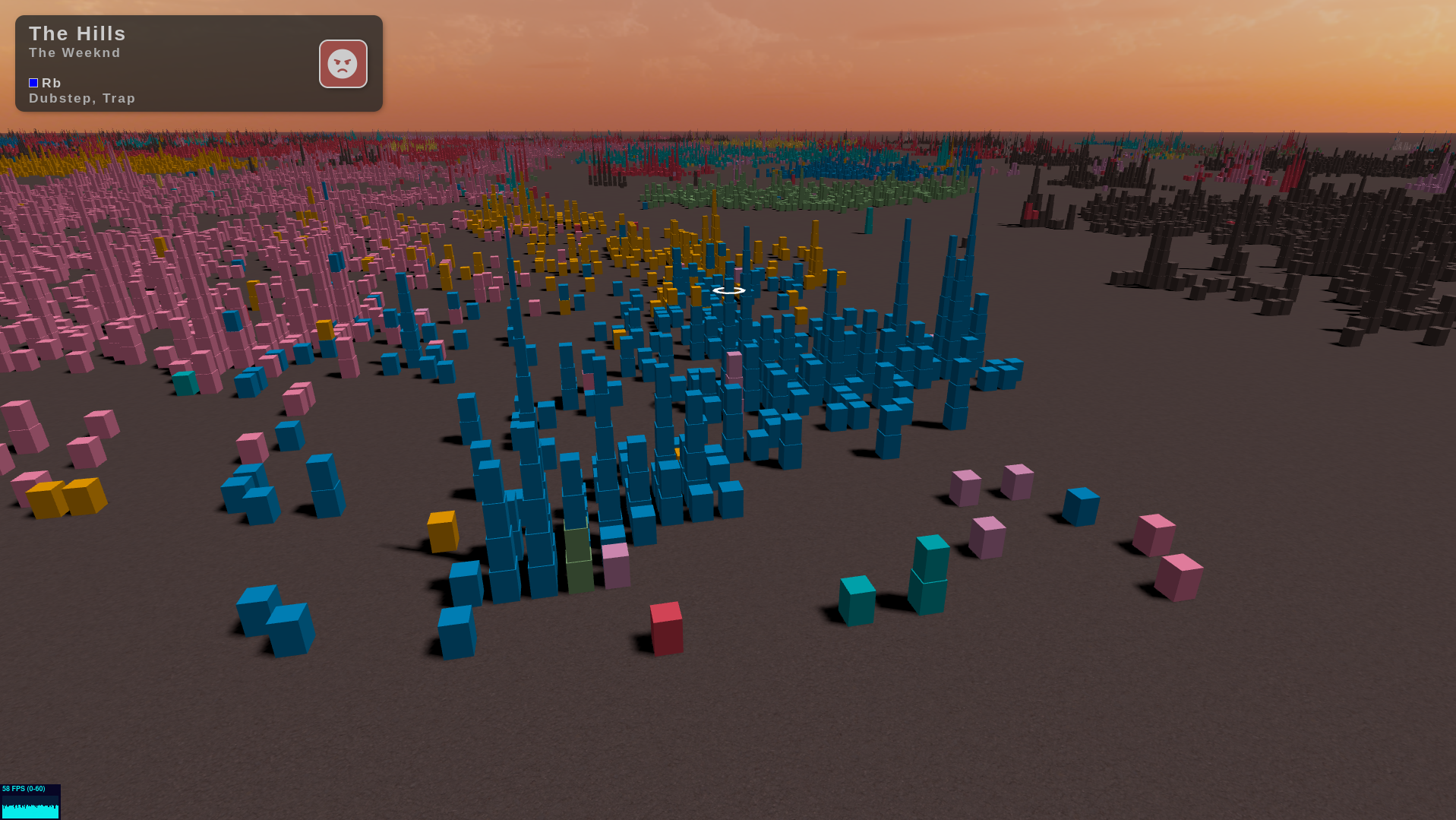

"Music Tower Blocks"

Für das Ars Electronica Projekt nahmen Schedl und sein Team die 500.000 populärsten Musikstücke her und stellten diese jeweils als Block dar. Ähnliche Stücke wurden zu Häusern gestapelt und in Genres zu Bezirken gruppiert. So entstand eine stadtähnliche Landschaft, durch die man als User wie in einem Flugsimulator mit den Handy navigieren konnte.

Der Bias eines Algorithmus’ kommt nicht von irgendwo – er entsteht durch die ungleiche Datenlage der wirklichen Welt, und durch den persönlichen Bias des jeweiligen Programmierers – und der ist in den meisten Fällen männlich. Heißt die Lösung also “Mehr weibliche Programmierer”? “Das höre ich horrend häufig”, winkt Schedl ab. “Auch wenn ich natürlich dafür bin, mehr weibliche Personen für Programmieren und Co. zu begeistern, greift das zu kurz. Es sollte mehr darum gehen, eine generelle Awareness zu schaffen”, bei Usern, aber auch bei den Entwicklern.

Denn am Ende bleibt eine Gewissheit: Der Algorithmus ist nur so gut wie sein Macher, und der macht die virtuelle Welt à la Pippi Langstrumpf „wide wide wie“ sie ihm gefällt.